数据中心网络布线为大数据时代铺路

2015-01-05

IDC研究表明:全球产生的数据量仅在2011就达到1.8ZB(或1.8万亿GB),且根据预测,未来十年全球数据存储量将增长50倍。ZB到底是多大容量的概念?1ZB的对象存储数据,相当于107亿块3T的硬盘,假设数据都是存储3份,一台服务器可以挂48块硬盘,那么需要2亿台服务器。假设一个机架可以放10台类似的服务器,那么将需要2000万个机架的服务器才容得下1ZB.

数据本身与通信技术的结合给现代人生活带来不可比拟的便利性,我们日常生活、工作的每一方面对网络与数据的依赖性越来越大,而所产生的数据需要有强大的网络通信技术与大容量数据中心作后盾。大数据时代对数据中心网络通信技术带来很大的挑战,本文将主要围绕大数据时代数据中心网络与布线系统的技术标准及网络基础设施物理层发展趋势作一下探讨。

一、大数据与网络技术发展的关系

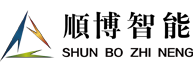

网络应用需求的快速上升是数据量需求产生的主要来源,我们可以从全球IP数据通信量增长的趋势中大致看到今后网络应用需求量的增长,如下图1.(Source: Cisco Visual Networking Index )

图1

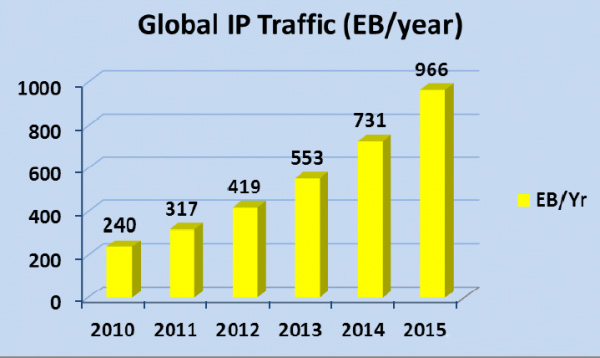

基于网络流量的增长与网络应用需求快速上升,IDC做出了今后几年全球数据量将迅猛增长的预期 ,如下图2显示了从2005年到2015年间的数据存储量的增长趋势。

图2

数据中心数据存储量增长与许多应用需求有关,笔者认为其中两个领域对数据量的增长影响明显:移动互连网与物联网。移动互连网应用近年来快速崛起,根据Cisco的市场报告统计,移动互连网产生的数据量年均增长达到90%以上,且移动终端的总量即将超过传统PC,这方面的增长将对全球数据量上升产生较大影响;另一方面物联网在越来越多的行业中得到了应用, “万物互联”是物联网的终极目标,这部分的数据增长是数据流量绝对量的增长。物联网的时代将是传感器自动不间断上传大量数据并通过网络储存在数据中心内,对网络与数据中心的存储量起到了很大推波助澜的作用。

网络是所有数据流通的基础,大数据的产生与网络技术的发展密切相关也是相辅相成,通信行业与IT行业需要更为紧密的“握手”才能使数据通信不产生瓶颈。事实上,网络基础设施也在朝着这个方向进行,目前国内的城域网干线网络正在思考升级到100G的网络,同时也在研究下一代400G的骨干。而为了支持移动终端的数据量快速上升,第4代移动通信LTE技术已经走向成熟,4G基站正在批量建设阶段。而对于通用住宅方面已经在快速推进FTTH光纤到户1G-EPON与10G-EPON的应用,种种网络基础设施的进步是为大数据产生与应用起到了桥梁纽带作用,大数据与网络基础设施的发展相得益彰,所有网络通信技术的进步是作为外围网络环境为大数据铺路。如果我们把外围的网络基础环境比作人体的神经,那么数据中心将是人体的大脑,而所有数据量的上升需要更大规模的数据中心与其相适应,对于数据中心内部的网络基础架构同样面临着进一步升级的需要,布线系统作为数据中心内部连接与管理的基础设施,对于数据中心的运行可靠性、可管理性及大数据流的支持起到了十分关键的作用

二、数据中心网络基础标准化发展应对大数据

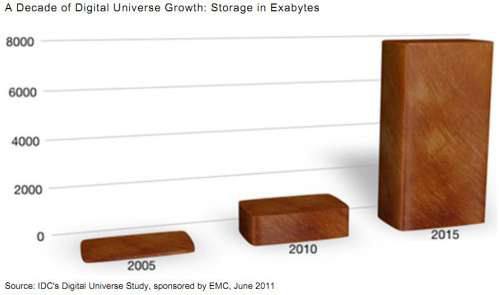

根据2012版本的TIA-942-A数据中心电信基础设施标准,对于数据架构基本还采用传统的网络架构模型,对于虚拟化的网络架构基本没有涉及。基于当前网络技术日新月异的变化状况,云计算虚拟化的网络发展特别是采用Fabric虚拟矩阵的网络将是大型数据中心网格架构的重要发展趋势,采用无阻塞的交换矩阵的网络结构是从网络层面应对大数据时代的技术手段之一。下图3为典型的虚拟矩阵架构网络。

图3

为应对大数据的挑战,云计算虚拟化网络技术的应用是必然的技术发展趋势,基于这样的网络架构的应用,2013年北美通信工业协会TIA正式批准了TIA-942-A-1新版数据中心基础设施标准的附录1,该附录从新的主流虚拟化网络架构并结合相应布线系统管理角度进行了定义。标准中网络架构涉及胖树型(Fat-Tree)、全网型(Full-Mesh)以及混合型的模块化矩阵全网型(POD-Interconnect-Mesh)等多种应用方式。此标准的及时批准对支持当前及今后一段时间内数据中心特别是云计算数据中心网络与布线系统的构建起到推动与促进作用,适应了大数据时代对网络的基础要求。

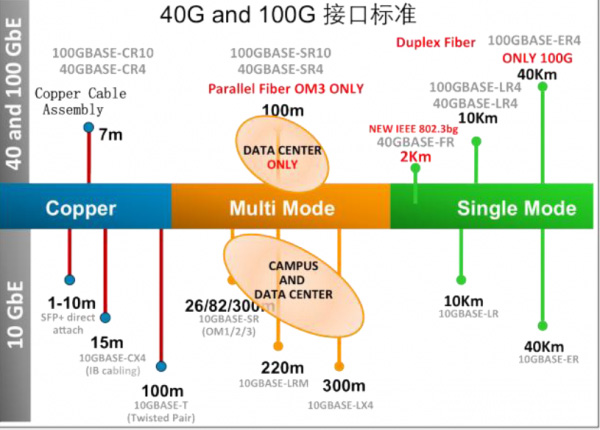

面临海量的数据存储与数据处理,数据中心为了提高资源利用效率与数据分析计算能力,将大量采用虚拟化云计算的技术,包括服务器虚拟化技术、网络虚拟化技术以及存储虚拟化技术等。网络架构总体的趋势将采用大二层虚拟化的网络,核心层采用40G/100G,接入层采用10G的方式基本已经成为网络升级的方向。当前可以参考的网络物理层的标准如下图4所示:

图4

在上述虚拟矩阵的数据中心主干网络中,更多地将从10G网络升级到40G/100G.IEEE 803.3ba已经于2010年已经正式发布采用40G/100G的网络技术标准,基于数据中心主干链路距离88%以上小于100米的距离,多模光纤OM3/OM4采用MTP与QSFP接口多通道并行传输的方式基于良好的性价比,被业界认为是数据中心主干链路应用的首选方案。当前标准中对于100G的应用方案采用的是10G*10的通道模型。2013年3月IEEE 802.3bm标准组织成立特别工作小组研究下一代基于多模OM3万兆光纤25G*4通道支持100G最小100米的标准,此预研标准对后续数据中心的应用影响明显,提高了光纤系统的应用密度,为后续更高级别的网络扩展提供了空间与物理基础。

基于当前数据中心内主干网络主要由光纤作为传输介质的背景,TIA标准化组织已经在研发基于100 Ohm平衡双绞线铜缆支持40G BASE-T的网络,草案标准

PN-568-C.2-1已经发行,预计正式标准将于2014年正式发行,发行后正式标准的编号将定义为ANSI/TIA-568-C.2-1.该标准将铜缆双绞线带宽扩展至2000MHz,预计将继续采用RJ45作为接口标准。定义铜缆级别为CAT.8,可以支持40G BASE-T网络传输距离达到30米的距离,基本满足数据中心40G链路55%的距离。铜缆支持40G的应用是对40G标准的一个重要补充,虽然距离比较短仅30米,在规模较大的数据中心主干内无法成为主流。但预期铜缆方案的成本优势将对大量规模较小的数据中心建设来说,是一种较有优势的方案,有助于促使数据中心更快及更大范围推进40G网络的应用。

三、支持大数据网络物理层技口技术分析

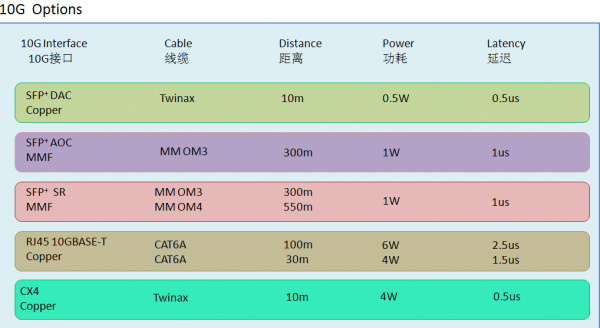

当网络主干走向40G/100G的高速网络时,数据中心接入层设备与服务器网络接口从1000M走向10G是必然,过去的接入层网络速率在1000M及以下,采用铜缆RJ45的接口模式在整体市场中处于主导地位。而当网络上升到10G时,将有多种接口模型可供选择,现阶段还没有一种接口在市场上形成绝对主流。当前10G接口类型较多,技术要求也差异较大,应用10G接口前需要对主流的技术方案进行综合评估与分析,以确定什么方案更符合各自的要求。下图5为目前市场上主流的10G接口及参数以供参考。

图5

以上5种类型10G接口所列出的数据仅供参考,由于10G的技术更新速度很快,不同时间阶段对于技术指标是有差异的。以上几中10G接口类型中,基于功耗、端口密度、支持距离等方面思考,笔者认为长远看CX4铜缆方案并不占有太大的优势。采用CX4接口的10G应用相对少,今后越来越少的用户采用基于CX4接口的10G 应用。而共余4种方式,我们可以通过几个应用方向进行分析,可以作为后续10G升级的参考选择。

1. SFP+ DAC的10G无源铜缆解决方案优点:接口功耗小,相对成本在4中方案中较低,延时较低,适应于虚拟化的网络环境。缺点:支持距离太短,基本只能适用于TOR(交换机置顶Top of the Rack)的网络架构,不可以自适应向下兼容1000M的网络应用。线缆本身故障需要带SPF+插头同步更换,维护成本相对较高。适用环境:应用于网络结构相对简单,设备变动、新增与移动较少且维护管理要求不高场合,如业务较单一的云计算模块化数据中心或互连网数据中心等。

2. SFP+ AOC的10G有源光缆解决方案优点:接口功耗较小; 成本比DAC略高但相比其余方案要低,支持距离最长可达300米,可以支持EOR等各种网络布线架构且光缆直径较小,可以应用于高密度机柜布置;延时较低, 适应于虚拟化的网络环境。缺点:不可以自适应向下兼容1000M的网络应用。线缆本身采用有源芯片电路,故障率相对高,出现故障需要带SFP+插头连同内部光电收发芯片同步更换,维护成本很高。适用环境:应用于网络管理简单、设备变动、新增与移动较少且对网络连接可靠性要求不高的场合,如云计算数据中心或第三方运维托管数据中心,以及网络结构单一的备份数据中心等。

3. SFP+ 10G BASE-SR的光缆解决方案优点:芯片技术成熟,接口功耗较小;支持距离较长,OM3光纤300米及OM4光纤550米,可以支持TOR、EOR等各种网络布线架构且光缆直径较小,可以应用于高密度机柜布置; 光模块与光跳线分离,无源光跳线可靠性高、日常维护方便、维护成本相对较低, 延时较低, 灵活适应于各种类型网络环境。缺点:不可以自适应向下兼容1000M的网络应用,总体方案成本相比较其他方案偏高。适用环境:应用于网络结构复杂、设备变动、新增与移动比较频繁且对网络连接可靠性与管理要求较高的场合,能适用于各类数据中心应用的需要,特别对于金融业,政府部门及各类企业级数据中心中应用更合适。

4. RJ45 BASE-T的铜缆解决方案优点:成本相对光纤方案要低,且可以向下自适应1000M网络。支持距离较长,最长可达100米,可以支持TOR、EOR等各种网络布线架构。铜缆跳线与端口有源芯片分离,布线可靠性高且日常维护方便、维护成本相对较低,灵活适应于各种类型网络环境。缺点:芯片技术还不太成熟,功耗相对较大,特别是长距离应用,线径粗不适合很高密度的机柜管理,延时相对大,对云计算虚拟化不利。适用环境:应用于网络结构复杂、设备变动、新增与移动比较频繁且对网络连接可靠性要求比较高但对密度要求不高且对机房节能要求不高的数据中心环境,如金融业,政府部门及各类企业级数据中心中。

需要关注的是,10G BASE-T的芯片技术还在不断演进,从早期10G BASE-T采用130nm的技术,到现在的40nm芯片技术,功耗已经从超过10W每端口降到的4-6W,今后还将有望进一步采用28nm芯片,预计功耗可以小于3W.各种10G接口技术都在进步,不同时期的优势特点也有变化,至于什么技术在市场上能笑到最后,仍需拭目以待。

四、大数据提升智能基础设施管理系统应用价值

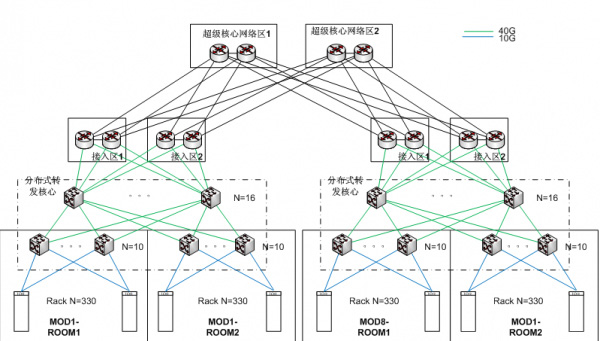

大数据时代的数据中心布线系统,我们不仅仅关注前面所述的作为10G/40G/100G的传输通道,管理是数据中心布线的另一项非常重要却易被忽视的功能。大数据的压力迫使数据中心发挥更高运算与数据处理效率,促进虚拟化技术在数据中心中更普遍的应用,而网络虚拟化技术却进一步加剧了物理层管理的难度。智能基础设施管理系统以管理为核心的理念将在今后的数据中心中发挥出更大的价值。参考以下图6虚拟化网络解决方案,下图为基于数据中心330机架*4总共1320个机架的网络规模,采用TOR的架构,TOR交换下行服务器机柜采用独立柜内布线的方式,这部分不是智能基础设施管理系统实时监控的重点,管理的重点是分布式转发核心区域,此区域实际部署过程中如管理不善极易混乱,采用智能基础设施管理系统对相应物理链路层路由进行主动管理模式,使得更复杂网络正确实施提供了保障。

图6

虚拟化网络为了降低延时提升数据转发效率,采用了非常复杂的交换矩阵,导致链路的连接关系非常复杂,采用传统手动工单对布线系统被动管理的方式将很难适应此类网络结构的管理,同时项目移交后对用户的后续日常维护将造成非常大的困扰。采用智能基础设施管理系统不仅仅能对布线系统进行操作指引与实时导航作用,更重要的是智能基础设施管理系统以流程化主动纠错的模式促使管理人员遵守标准的IT流程化管理要求,提高网络与基础设施的维护效率与管理水平,杜绝因操作错误造成系统宕机风险与损失。

大数据时代的数据中心网络核心交换矩阵将采用40G/100G,核心主干物理层网络是智能基础设施管理系统的管理重点。与传统数据中心相比,如采用相同的行业模型来分析投资回报率ROI,假设对于传统10G核心网络,由于管理原因造成数据中心网络中断问题产生的损失是1个单位,而大数据采用40G/100G网络在相同宕机时间的损失可能是4-10个单位。显然,在大数据时代对于智能基础设施应用的投资回报率更高,从而促使智能基础设施管理系统应用价值得到了提升,促进智能基础设施更广泛地应用在数据中心内。

五、结束语

大数据的时代是数据应用需求的急速增长作为驱动的源泉,云计算是基于虚拟化技术发展而来,不仅仅为大数据计算处理提供技术保障,同时云计算本身也是一种服务模式,从某一方面来说云计算的大量落地也是促进了大数据发展的原因之一,两者相辅相成。对于网络的基础架构来说,在大数据与云计算相互促进的背景下,网络基础为了不成为整体应用发展的瓶颈,需要整体网络技术不断的升级,包括外围的干线网络、LTE第四代移动网络以及FTTH光纤到户等。而数据中心的物理层网络是支持云计算大数据的核心,也是最迫切需要得到提升的关键基础设施,数据中心网络物理层行业标准化发展相比较实际应用需求保持一定的领先性,10G/40G/100G等网络基础与接口技术逐步走向成熟为大数据铺平了道路。大数据时代数据中心网络基础的复杂性,又使得智能基础设施管理系统的应用价值得到了良好的体现。数据中心网络基础技术已经作好准备以迎接大数据时代的到来。